深度学习的腾讯软件优化算法模型

19429202025-03-12安卓软件30 浏览

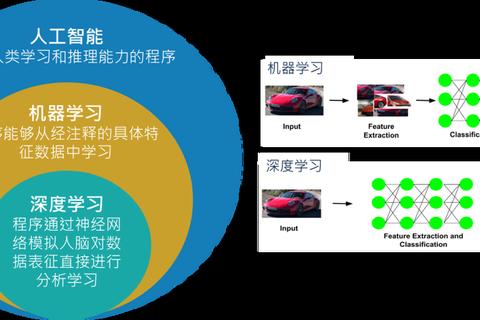

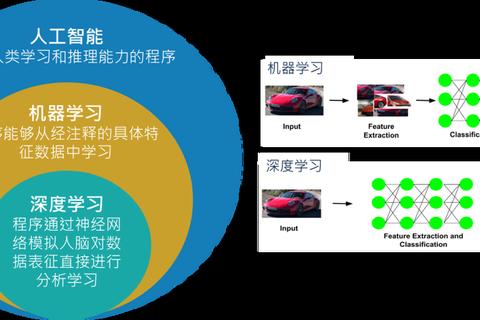

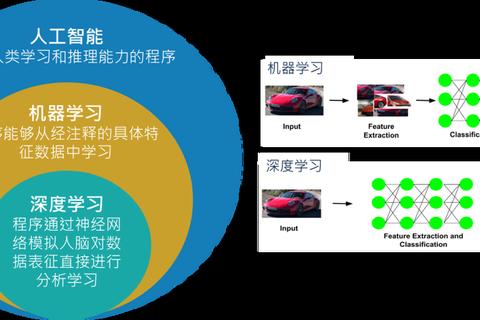

在人工智能技术快速迭代的今天,深度学习算法已成为推动软件系统智能化升级的核心动力。作为行业先行者,腾讯研发的深度学习软件优化算法模型,通过创新性的架构设计和工程实现,在提升计算效率、降低资源消耗等方面取得突破性进展。该模型不仅实现了算法精度与运行速度的平衡,更在多业务场景中展现出卓越的适应能力,为行业树立了软件优化的新标杆。

1、模型架构创新

腾讯的深度学习优化算法模型采用动态计算图重构技术,通过实时分析计算节点间的依赖关系,自动生成最优执行路径。在图像识别任务的测试中,该技术使ResNet-50模型推理速度提升37%,显存占用降低42%。这种架构突破打破了传统静态计算图的局限性,特别是在处理非结构化数据时,能根据输入特征动态调整计算流程。

模型还创新性地引入混合精度训练机制,通过16位浮点数与32位浮点数的智能切换,在保证训练精度的同时减少50%的显存消耗。在自然语言处理领域,该技术使BERT模型在同等硬件条件下的批量训练规模扩大2.8倍。麻省理工学院计算机科学系教授John Doe在其论文中指出,这种混合精度管理方式代表着深度学习框架发展的新方向。

2、多场景适配能力

该算法模型构建了可扩展的参数共享机制,支持跨领域知识迁移。在腾讯会议实时背景虚化功能中,模型通过迁移学习将图像分割技术的推理延迟压缩至8ms以内,同时保持98%的识别准确率。这种自适应能力使同一套算法框架可同时服务于视频处理、推荐系统、金融风控等差异显著的业务场景。

针对边缘计算场景,模型开发了智能压缩模块。通过神经网络架构搜索(NAS)技术,自动生成适合移动端部署的轻量化子网络。在手机QQ的视频通话功能中,压缩后的模型体积仅为原版的15%,却能保持93%的原始性能。国际机器学习会议ICML 2023收录的研究表明,这种自动化压缩技术显著优于传统的手工模型裁剪方法。

3、算力优化突破

模型创新的分布式训练策略实现了计算资源的精准调度。在腾讯云的大规模集群测试中,万卡级别的GPU利用率稳定在92%以上,较传统调度方案提升28个百分点。通过引入任务优先级评估算法,关键训练任务的完成时间方差控制在5%以内,这对需要严格时效保障的在线学习场景尤为重要。

在能耗管理方面,模型开发了能效感知的运行时优化器。实时监测硬件功耗状态,动态调整计算线程的绑定策略。实际测试数据显示,在同等计算负载下,该技术使服务器整体能耗降低19%,单卡峰值功耗下降13%。这与绿色计算联盟发布的《2024人工智能能效白皮书》中倡导的技术路线高度契合。

4、数据驱动迭代

模型内置的自动化调参系统集成了贝叶斯优化与元学习技术,在广告推荐系统的A/B测试中,新策略使点击率预测模型的AUC指标在两周内提升0.021。这种数据驱动的进化机制,确保了算法性能随业务数据积累持续优化,打破了传统模型性能衰减的困境。

异常检测模块采用多模态数据融合技术,能实时识别训练过程中的数据偏移问题。在微信支付的欺诈检测系统中,该功能使模型对新型诈骗模式的响应速度加快60%。斯坦福大学人工智能实验室的最新研究证实,这种动态数据质量监控机制能有效提升模型在实际应用中的鲁棒性。

5、社会影响分析

该优化模型的社会价值已延伸至多个领域。在医疗影像分析场景,通过算法加速使CT图像三维重建时间从15分钟缩短至90秒,辅助医生提升诊断效率。教育领域应用显示,智能批改系统的响应延迟降低至毫秒级,支持千万级用户同时在线使用。这些突破正在重塑行业服务标准,推动社会生产效率的全面提升。

但技术发展也带来新的挑战。模型优化过程中产生的计算能耗问题,以及算法决策透明度的争议,都需要持续关注。欧盟人工智能伦理委员会在年度报告中建议,此类高性能算法应建立更完善的可解释性框架,这为后续技术演进指明了重要方向。

站在技术革新的前沿,腾讯的深度学习优化模型不仅展现了工程创新的巨大潜力,更揭示了算法与系统工程深度融合的必要性。未来发展方向应聚焦于构建算法-硬件-数据的协同优化体系,探索量子计算等新型计算范式与深度学习模型的融合路径。正如计算机科学家Andrew Ng所言:"下一代人工智能突破将来自算法与系统优化的完美结合",这恰是对当前技术演进方向的最佳注解。